Y como lo prometido es deuda, comienzo con las charlas de hoy, concretamente las del WebQuality 2012.

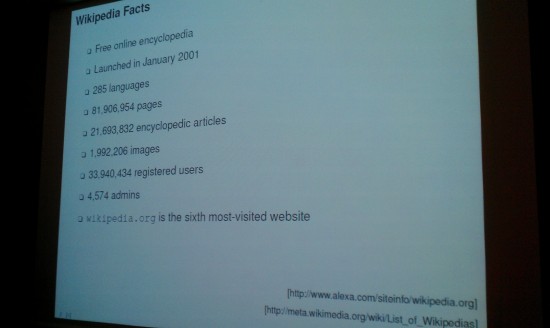

Comenzamos con un cambio en el programa, así que toca A Breakdown of Quality Flaws in Wikipedia (Maik Anderka y Benno Stein). La idea es investigar la calidad de la Wikipedia, ya que es muy grande: tiene cerca de 90 millones de páginas, 22 millones de artículos y es la sexta web más visitada del mundo.

Para la calidad hay algunos elementos como que cualquiera puede editarla, los autores son muy distintos y las ediciones nos e revisan antes de la publicación. Esto implica que las mejoras sean de baja calidad y que sea difícil mantener la alta calidad.

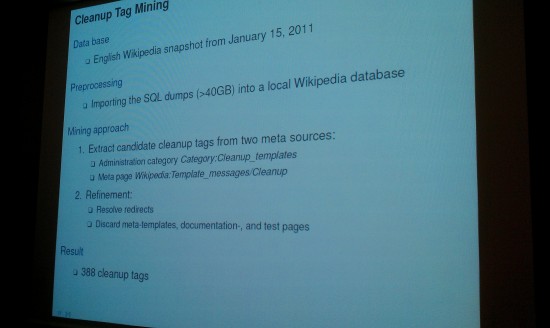

Sólo un 0,1% de los artículos de la Wikipedia en inglés son destacados… ¿qué ocurre con el otro 99,99%? Cualquiera puede marcar artículos como incompletos o completos. La idea es intentar hacer un sistema que revise las diferentes plantillas y genere un sistema de organización automático.

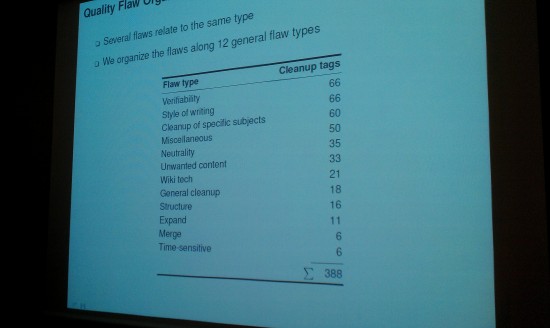

La reorganización se hace en base a dos tipos de limpieza: la primera es la de la reorganización por tipo, de las cuales el sistema principal es la verificabilidad.

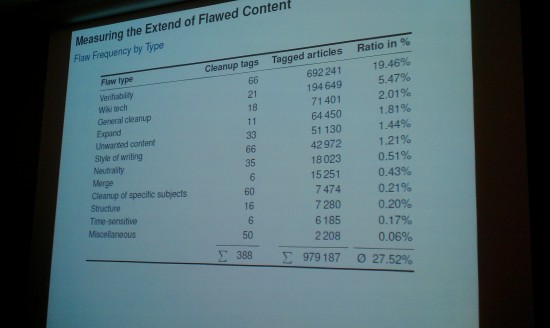

La segunda revisión hace referencia al alcance de los contenidos, en concreto, a los defectos que tienen. En general los problemas (la mayoría) se encuentra en los artículos enciclopédicos (vamos, las páginas de consulta) aunque se pueden encontrar también muchos errores en los ficheros o incluso en las propias plantillas que se usan para los artículos.

¿Qué tipo de artículos son los que más defectos tendrían? La mitad de los artículos sobre informática contienen defectos, seguidos de los referentes a las creencias. Una cuarta parte de los que hacen referencia a cronología, matemáticas y un 20% de geografía contienen algún tipo de defecto.

¿Cuáles son los tipos de defectos más habituales? Un 20% hacen referencia a la verifiabilidad.

Si se organiza de forma correcta y nos basamos en artículos ya verificados, se podría llegar a detectar un 40% de artículos que tienen algún tipo de defecto hasta corregirlos. Se está organizando una competición para detectar la previsión de errores en la Wikipedia.

Se ha llevado a cabo un trabajo sobre la corrección. Un 25% de los artículos se han corregido, de los cuales un 70% tienen problemas de verificabilidad.

La siguiente presentación es On Measuring the Lexical Quality of the Web (por Ricardo Baeza-Yates y Luz Rello).

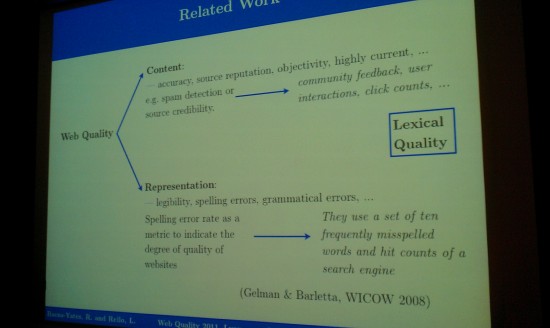

Medir la calidad de una página web es el mayor problema de los motores de búsqueda hoy en día, o sea, cómo rankear las páginas. Todo depende de la calidad semántica intrínseca. Para comenzar se analiza la cantidad de palabras que se usan en «el mundo real» y luego su relación con su uso en la red de redes, aunque después se han propuesto también la integración de errores tipográficos y semánticos.

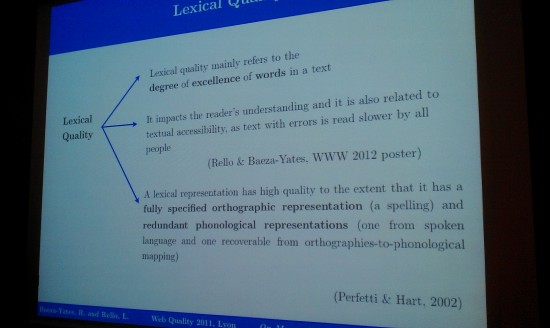

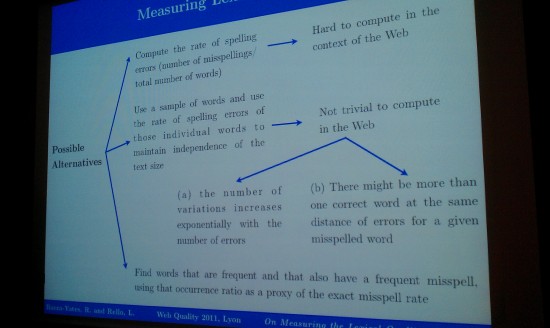

Para medir la calidad del léxico debe ser independiente del tamaño del texto o de las páginas de un sitio y compararlo con cualquier otro tipo de documento y/o tamaño.

La calidad léxica depende de la relación de las palabras con faltas de ortografía y la palabra escrita correctamente. De esta forma se saca un ratio general de cómo escribe la gente. Hay varias condiciones: frecuencia, el ratio más alto de faltas de ortografía y la desambiguación (nombres, acrónimos, palabras en otros idiomas…)

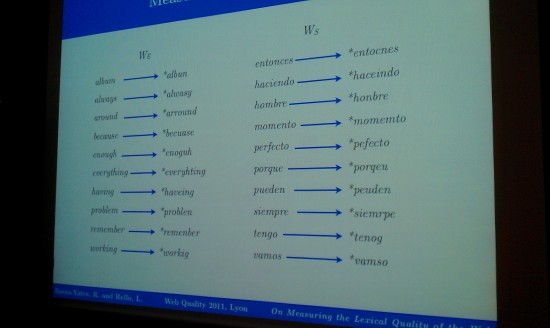

Algunas de las palabras con más errores de ortografía son las siguientes:

Es curioso porque los ratios no se pueden comparar entre idiomas, ya que las curvas entre cantidades de palabras pueden variar significativamente.

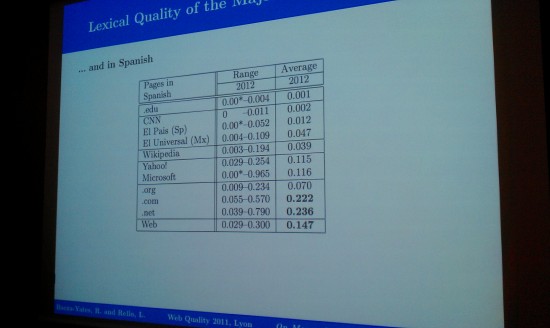

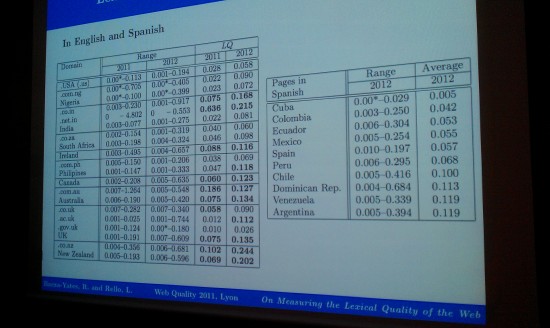

La calidad del idioma inglés según Google en marzo de 2011 es de 0,047, en el caso de Yahoo! es de 0,099. Usando una colección web de 28.000 documentos se puede alcanzar una cifra de 0,037. Además, si comparamos Google y Bing con el paso del tiempo (2011 vs. 2012) podemos comprobar que la calidad léxica va empeorando (en los análisis aparece que Bing tiene el doble de peor calidad léxica que Google). Como detalle, los contenidos de la CNN son bastante malos, principalmente por los comentarios (un 50% de baja calidad léxica). En el caso de dominios .EDU o .AC.UK pasa todo lo contrario. Incluso, la Wikipedia o la ODP tienen un ratio de mejor calidad que los sitios académicos.

En el caso del español la calidad es bastante mejor que la inglesa. Aunque en el caso de las redes sociales la calidad está por debajo de la media. Un sitio que tiene una gran calidad léxica es Flickr, aunque tiene poco contenido textual.

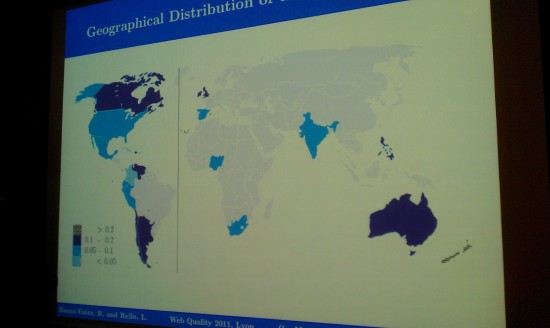

Cuanto más acceso a Internet existe, más posibilidades de baja calidad, ya que el acceso a la red llega a todo tipo de niveles culturales y eso empeora la calidad. España está en una calidad media en estos momentos, al igual que Estados Unidos. Es decir, el nivel cultural y la cantidad de conexiones a Internet influyen en la calidad de los contenidos.

La relación, en general, de la calidad de los contenidos y los contenidos de un mismo sitio web es alta. También es básico analizar la calidad léxica de la red cada poco tiempo ya que es bastante cambiante.

La siguiente charla es Measuring the Quality of Web Content using Factual Information (de Elisabeth Lex, Michael Voelske, Marcelo Errecalde, Edgardo Ferretti, Leticia Cagnina, Christopher Horn, Benno Stein y Michael Granitzerg).

Hay que intentar tener presentes algunos puntos: sacar estadísticas simples de hechos de un texto, sacar información relacional de los hechos y buscar relaciones semánticas. Una primera aproximación es mirar las funcionalidades estadísticas del documento, cuñan informativo y qué cantidad de datos abiertos dispone.

Un detalle es que los documentos largos suelen contener mayor cantidad de hechos, y que hay que comparar documentos de una misma longitud y de distintas longitudes para extraer información, algo que en principio no es muy importante. En el caso de sacar cantidad de hechos en documentos de una misma cantidad de palabras sí que influye, ya que la aproximación es más exacta.

La última presentación es A Deformation Analysis Method for Artificial Maps Based on Geographical Accuracy and Its Applications (de Dasiuke Kitayama y Kazutoshi Sumiya). En este caso se analiza la información y fiabilidad de los mapas.

En general los mapas tienen muchas deformaciones (ejemplo claro es el de los mapas del metro) tanto en distancias como en formas, ya que no cuadran geográficamente casi ningún dato. El objetivo de este trabajo es el de extraer la información de un mapa «falso» (poco preciso) relacionarlo con un mapa real (por ejemplo un Google Maps) e intentar trasladar las coordenadas para sacar una idea correcta y precisa.

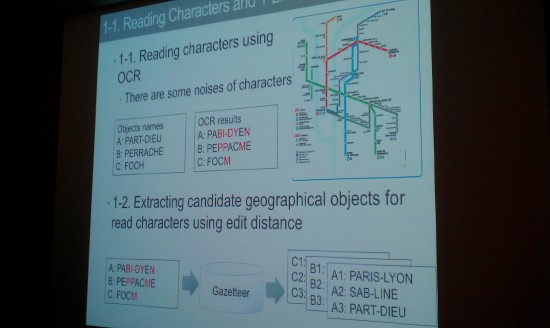

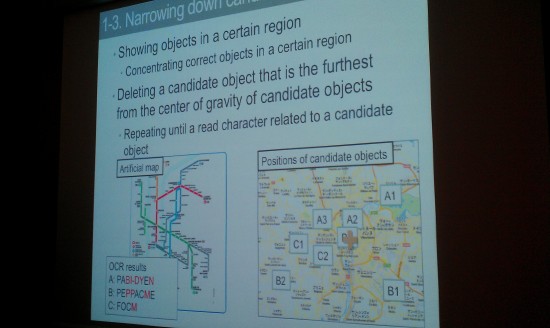

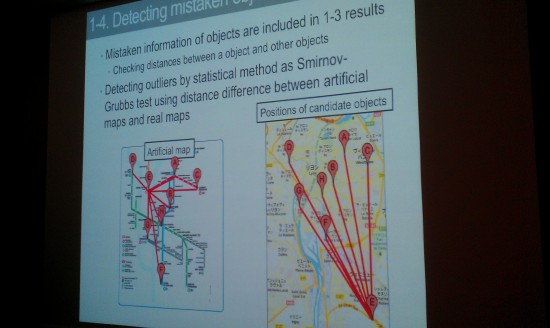

Para ello se pueden sacar informaciones por OCR (como nombres de estaciones o lugares), de ahí se sacan los datos geográficos, se busca el lugar más preciso para situarlos y finalmente se buscan lugares situados incorrectamente.

Una vez se han situado los puntos, se saca una triangulación para ver el desvío de los mapas. Para analizar el sistema, se ha hecho un proceso automático y luego uno manual que analiza (por personas) si la información situada en los mapas es correcta. Uno de los problemas mayores es la lectura de los lugares del mapa, del que sólo se pueden sacar un 61% de los datos).

En cuanto a la traslación de los lugares a puntos correctos del mapa, la información tiene una precisión del 62%, eso sí, cuando la traslación de datos es correcta, los mapas quedan con muy buenos resultados.

En un futuro, uno de los trabajos a realizar es interpretar líneas tratadas como carreteras o ríos para aumentar la credibilidad y precisión.

Deja una respuesta