Aquellos que todavía sigan creyendo que Google se inventa las cosas y que se las saca de la manga es que no sabe que en Estados Unidos hay que patentarlo todo. Y en previsión de que la patente estaba a punto de concederse (concretamente fue concedida ayer día 14) se ha lanzado hace poco… Como esta hay otras tantas, pero quizá cabe destacar algunos elementos que la convierten en la semilla del Panda.

La patente se llama Deriving and using document and site quality signals from search query streams y tiene como resumen lo siguiente:

A system analyzes one or more search streams to detect one or more associations between a document and one or more queries in the one or more search streams. The system further derives a value for the document based on the detected associations and uses the derived value in evaluating a quality of the document with respect to one or more subsequent queries.

Lo que viene a significar:

Un sistema analiza uno o más textos para detectar una o más asociaciones entre un documento y una o más consultas de búsqueda de uno o varios textos. El sistema además deriva un valor para el documento basado en las asociaciones detectadas y utiliza el valor obtenido en la evaluación de la calidad del documento con respecto a una o más consultas de búsqueda posteriores.

Lo primero que voy a comentar son los problemas a los que se enfrenta Google, es decir, cómo funciona Google hasta ese momento (que como podréis ver hace mucho hincapié en el tema de los enlaces, algo que, parece ser, «ya no sirve»).

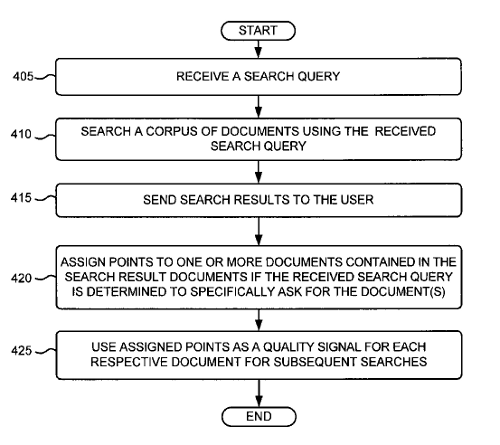

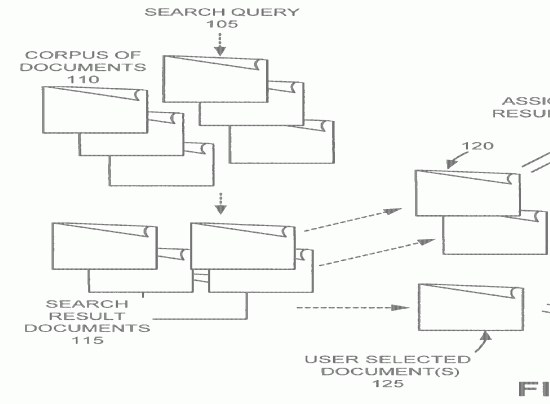

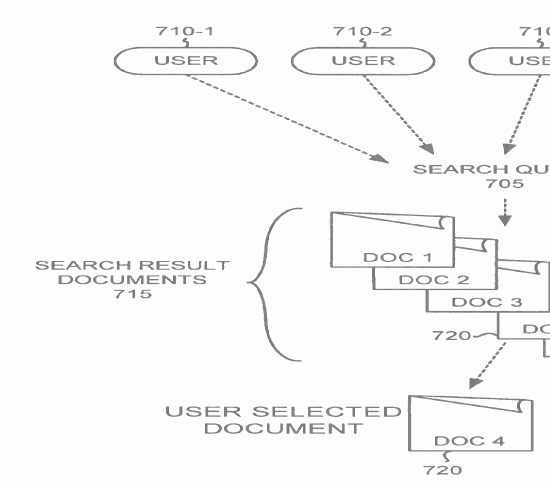

La base de todo es el sistema que permite analizar una página en concreto, según unas consultas de búsqueda, y que tiene en cuenta el anchor text, la pluralidad de documentos, las coincidencias de búsqueda, el anchor text de los enlaces y que determina los enlaces que apuntan a un documento asignándoles un peso determinado y durante un periodo de tiempo, todo ello basado en las consultas de búsqueda. Con esto básicamente tendríamos el análisis del historia de los usuarios, su relación con las páginas visitadas y la asignación de un punto de calidad a dichas páginas.

Además de esto, que vendría a ser el Pagerank con esteriodes (que se vino usando hasta 2001) y que se usa como base en Google, hay que sumarle otra decena de factores que tienen más importancia que la anterior. Por ejemplo, si el texto que se busca es el mismo que el que hay en el enlace, ya sea de forma limitada o ilimitada, visitado por uno o múltiples usuarios, a través de distintas conexiones de red y por un periodo de tiempo.

Pero aquí entran algunos detalles más. Si hay un exceso de enlaces (en relación a las búsquedas que han hecho los usuarios sobre esa página) el valor de los mismos se pierde. Esto sería básicamente lo que genera el Sandbox y lo que «esos que dicen saber de SEO» creen que hay que hacer enlazando el primer día desde muchos sitios. Este error típico (y el no usar los Sitemaps y otros métodos) es lo que provoca que un sitio que no tiene tráfico ni nadie ha navegado por él acabe cayendo en una penalización por malas prácticas. Lo malo de esto es que podía llegar a afectar a los sitios desde los que son enlazados y a los que enlaza esa página. De ahí que el Sandbox ya se estuviera aplicando en esa época…

Otra cosa que parece tenerse en cuenta es la cantidad de consultas que se hacen desde muchos dispositivos y redes (es decir, que te busque gente desde múltiples sitios, países, dispositivos, plataformas…) y que de la lista de resultados elijan el tuyo frente al resto por un periodo de tiempo particular. Esto nos lleva a tener muchas consultas de búsqueda iguales y que acaben yendo siempre a las mismas páginas, y en las consultas siguientes.

También se detectan aquellos resultados que reciben más visitas en determinadas consultas de búsqueda por unos periodos de tiempo limitados y se les asigna, una vez más, determinados valores de calidad.

Básicamente, en este momento lo que se viene a decir es que, hasta ese momento la calidad de las páginas, en su gran mayoría, se hacía testeando la mayor cantidad de usuarios distintos (navegadores, conexiones a Internet, dispositivos…) y que en base a su forma de navegar por los resultados de búsqueda, y la información de enlaces que hay en las páginas resultantes, se asignan pesos de calidad. Esto quiere decir que, hasta 2001 el Pagerank era prácticamente todo, que entre 2001 y 2005 el cálculo de calidad seguía basado en el linking (principalmente interno) y en lo que los usuarios visitaban en los resultados de búsqueda.

¿Qué es lo que se propone la nueva fórmula secreta? Encontrar nuevos factores que determinen la calidad de un sitio o página. Para empezar hay un gran problema: aunque Internet es algo limitado, el crecimiento es muy grande, la información cambia y, como situación más destacada es que el número de usuarios «inexpertos» en la red aumenta exponencialmente.

Los buscadores por norma general lo que hacen es buscar lo que el usuario está consultando y se devuelven enlaces / contenidos que incorporan dicha información basado todo en la información ya analizada, es decir, la que se tiene guardada desde hace ya «un tiempo» (aquí podríamos venir a decir que, previo a esto tenía que lanzarse Caffeine, que soluciona esta situación de «información no cambiante», ya que Caffeine precisamente lo que solventa es que se indexe el llamado «tiempo real y social»).

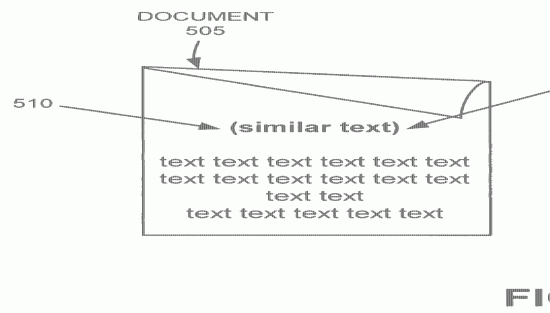

Para devolver los mejores resultados hay que medir la calidad de los documentos (como pueden ser las páginas web). Un sistema de análisis es el que he comentado anteriormente (el que se basa principalmente en los enlaces y en el comportamiento histórico sobre la navegación en los resultados de búsqueda), pero otras formas de analizar la calidad se pueden llevar a cabo en el momento de indexación de la propia página. Un ejemplo sería el de encontrar información solicitada en la consulta de búsqueda en el título de la página, que tendría más peso que encontrarlo e el pie de página. De la misma forma, los textos en negrita, cursiva, texto mayor tendrían más peso que el texto normal. Otro detalle podría ser que todas las palabras dentro de la consulta de búsqueda estén en el documento en vez de sólo encontrar algunas de ellas. Esto generaría un peso sobre la página que podría ayudar a medir la calidad.

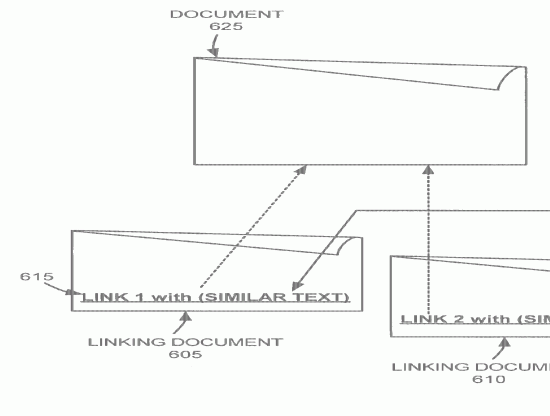

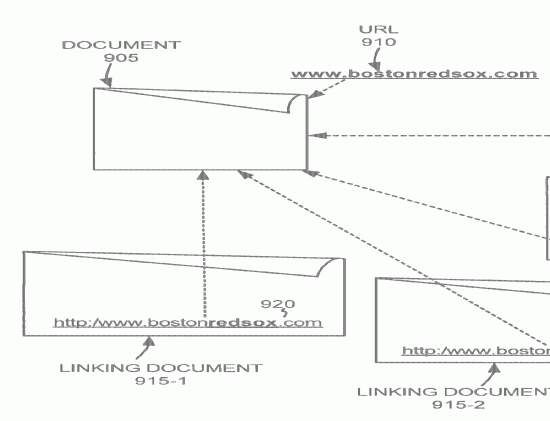

Además (y esto es importante) existe un valor de calidad medible en base a los enlaces que se puede combinar con el anterior. El Pagerank es algo que sigue teniendo en cuenta los hipervínculos entre documentos, pero a veces esta estructura (que debería ser lógica) no existe, es poco fiable limitada en el tiempo o limitada en cuanto en tanto no da fiabilidad al Pagerank. Como decía antes, lo siento por «esos que dicen saber de SEO» porque, como vengo diciendo desde hace años, los enlaces sin ton ni son no sirven para nada. Eso sí, aquellos que están bien construidos tiene muchísimo peso (algo que también le dará la razón a algunos que conozco que dicen que los enlaces sí que les funcionan, y que sé que lo tienen bien montado ya sea manual o automáticamente).

A parte de esto, el sistema también analizará y tendrá en cuenta las consultas de búsqueda que se hagan y las siguientes consultas reacionadas (o no) para determinar cierto nivel de calidad. Esto vendría a relacionarse directamente con el efecto MayDay, en el que hubo muchos cambios en relación al long-tail y short-tail, que podría venir relacionado con cómo hace consultas la gente a los buscadores. El nuevo algoritmo primará el que el contenido de la página tenga relación con el texto que viene en la consulta de búsqueda. Esta consulta de búsqueda podrá considerarse también como un propio factor de calidad del documento en el que el usuario acabe visitando. Esto implicaría, que aquellos enlaces que se encuentran en estas páginas de calidad y que vayan dados con palabras similares a las de la consulta de búsqueda tendrán también más peso (o sea, que si enlazas a sitios de calidad, tu sitio también gana).

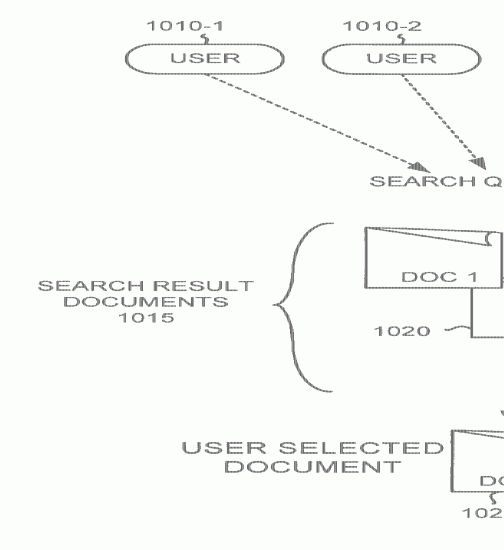

Además, y aquí quizá tenemos un punto que pocos han podido tener en cuenta, es que si tu página está bien valorada y puede estar muy relacionada con otra que se le parezca, esa otra página puede aparecer también en los resultados, pudiéndosele asignar un valor de calidad en siguientes consultas si así se lo merece.

Otro detalle que se comenta, aunque es más un «se deja ver» que algo directo, es que si un usuario tiene algo en mente y lo encuentra, eso es importante… ¿qué significa esto? pues que si alguien pone directamente el nombre de un dominio o una frase muy concreta y acaba pulsando en un resultado de búsqueda que es eso que buscaba, eso tiene también muchos puntos de calidad. Al fin y al cabo, como siempre, la lógica y el sentido común priman sobre cualquier invento o estrategia que se quiera alguien sacar de la manga. Simple.

Queda muy claro que estos conceptos son muy básicos y que es la idea de lo que puede llegar a hacer es enfocarse en la calidad de los contenidos y de las páginas eliminando aquellos que o son útiles y quitándole peso a los enlaces que no estén bien construidos.

Por ejemplo, un detalle que se comenta finalmente es que un sitio que tiene varios documentos importantes para una serie de consultas también ganaría peso, haciendo que cualquier otro contenido que se publique automáticamente tenga cierto nivel de calidad. Estos «sitios» pueden ser un dominio, un hostname, una red (una empresa o red de blogs, por ejemplo) e incluso los documentos creados por una misma persona (¡anda! si el otro día salió lo del rel=»author» por ahí) e incluso una forma determinada de escribir.

Por cierto, para el que no lo sepa, Google Panda Update se llama así gracias a su «ideólogo», Biswanath Panda, experto e el tratamiento de grandes cantidades de información.

Para acabar, hay que tener en cuenta que esta patente va muy relacionada con algo que ya comenté hace unas semanas, relacionado con la distribución de la calidad y con el resumen que hice hace un par de días en el que, al final, simplemente se trata de hacer las cosas bien… Hay que tener en cuenta que, antes de aprobar esta patente, ya existían otras tantas en las que se habla de cómo distribuir los pesos o lo que comentan del análisis del comportamiento de los usuarios a la hora de hacer consultas y visitar sitios concretos, además de la extensión de la calidad a otros lugares que no son simplemente la propia página…

Al fin y al cabo, Google lo que intenta plantear que lo que se pudo ver ayer en el Google Inside Search, que quieren potenciar el primer resultado tanto para búsquedas en escritorio como en dispositivos móviles.

<mode ego ON>

Mola que @mattcutts te conteste por una cagada en google.com, ¿eh?

<mode ego OFF>

Responder a Aníbal Cancelar la respuesta