Estos días, con eso del Farmer Panda Update se está hablando mucho de la baja calidad de los contenidos. Aunque ahora mismo en realidad no se está atendiendo realmente a la calidad de los contenidos con respecto a su credibilidad, sí que se están revisando la calidad de una página con respecto al resto de páginas de un sitio. Pero de eso ya he hablado, así que voy a ir a por lo otro: la credibilidad.

Estos días se ha presentado un documento muy interesante llamado Augmenting Web Pages and Search Results to Support Credibility Assessment y reducido a «una palabra»: WebCredibility. Este documento está desarrollado parcialmente por Microsoft Research y básicamente detalla formas a tener en cuenta a la hora de intentar saber si un sitio (y una página concreta) es creíble o no.

El documento empieza con una frase muy interesante: The internet is increasingly becoming a primary source of information for people around the world algo que es completamente cierto… hoy en día todos nos fiamos de lo que se pone en Internet, aunque sabemos perfectamente que no nos podemos creer todo, porque cualquiera puede publicar. Entonces ¿cómo saber qué es verdad y qué no lo es?

Para empezar hay que buscar entre 4 tipos de credibilidad:

- Credibilidad presumible: basado en hipótesis generales que dan fuerza a la mente de los usuarios. Un ejemplo sería el uso de un dominio .GOV.

- Credibilidad de superficie: basada en una primera ojeada al sitio y lo profesional que puede aparentar.

- Credibilidad ganada: basada en la confianza a través del tiempo y que puede tener relación con la usabilidad del sitio y la arquitectura a la hora de ofrecer información.

- Credibilidad por reputación: basadas en las opiniones de terceros, premios, certificados…

Es curioso que 2/3 de los estadounidenses crean que los resultados proporcionados por los buscadores son «justos e imparciales» a la hora de ordenar los resultados, sin tener en cuenta la existencia propia del SEO, algo que no hace más o menos creíbles los sitios, sino que se basan en factores que los buscadores utilizan a la hora de generar la lista de resultados.

La credibilidad de una página se mide en base a esta premisa: A credible webpage is one whose information one can accept as the truth without needing to look elsewhere. If one can accept information on a page as true at face value, then the page is credible; if one needs to go elsewhere to check the validity of the information on the page, then it is less credible.

Para entender parte de cómo gestionar la credibilidad de un sitio podemos basarnos en algunos informes o estudios previos. Para analizar el contenido podemos usar el Open Information Extraction (PDF) aunque este sistema tiene problemas con el lenguaje natural o «de la calle». Otras formas de detección son What is Disputed on the Web? (PDF) y el sistema BLEWS: Using Blogs to Provide Context for News Articles (PDF).

Otra cosa que se puede plantear es la predicción de la credibilidad de un sitio. Para ello se pueden usar técnicas como el Combating Web spam with TrustRank (PDF) (a.k.a TrustRank) and Countering Web spam with credibility-based link analysis (PDF) (a.k.a. CredibleRank). Estos sistemas básicamente observan y analizan la estructura de enlaces interna de un sitio y le dan una puntuación de credibilidad. De todas formas, estos sistemas no analizan la credibilidad en sí sino el Web Spam.

Para acabar encontramos la manera en la que se informa a los usuarios de la información incorrecta o poco precisa, y un ejemplo claro vendría a ser el historial de las páginas de la Wikipedia que permiten visualizar los cambios a través del tiempo. También existen organismos como el HON (que certifican la información médica) y que tienen en cuenta muchos factores.

A la hora de hacer un análisis in-vitro se utilizan ciertos valores con los que medir, que son los siguientes:

- Elementos On-Page: son aquellas características que están presentes, pero son complejas de determinar para un usuario.

- Errores ortográficos: revisando que la escritura sea correcta.

- Publicidad: se comprueba la cantidad de anuncios que se sirven por página.

- Tipo de dominio: los usuarios no se fijan en la URL y puede llevar a una falta de seguridad (ver Do security toolbars actually prevent phishing attacks (PDF)).

- Elementos Off-Page: son aquellas características en las que el usuario ha de ver en otros sitios para conseguir datos suplementarios.

- Premios: se recopila información de premios como los Webby Awards, Alexa, organizaciones como HON…

- PageRank: se recopila la información pública (desde la barra de herramientas) de cada página del dominio.

- Compartido: datos de herramientas como Bit.ly, páginas compartidas en Facebook o número de bookmarks en delicious.

- Elementos Agregados: son elementos a los que los usuarios no tienen acceso, como por ejemplo el comportamiento que se puede recopilar por la barra de herramientas de Bing (datos de +50 millones de usuarios).

- Popularidad general: visitas únicas que ha tenido la página.

- Alcance geográfico: cantidad de lugares geográficos distintos desde los que se ha accedido.

- Tiempo de espera: tiempo que el usuario ha estado en la página.

- Re visita: cuantas veces los usuarios han vuelto a visitar la página.

- Popularidad experta: no todos los usuarios son capaces de determinar la credibilidad de un contenido y se analiza el comportamiento del usuario basada en su navegación anterior, contando el tiempo en otras páginas, etc…

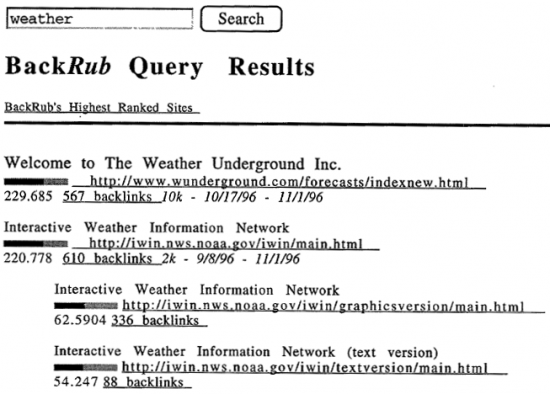

El informe da ciertos datos interesantes que habría que tener en cuenta. Por ejemplo, uno de ellos dice que si los resultados de búsqueda dan más información sobre la página, los usuarios mejorarán la navegación y su decisión sobre la credibilidad del sitio. Un ejemplo sería el que BackRub (lo que después se convirtió en Google) tenía y donde aún puede verse algún ejemplo.

Sin duda este estudio es un buen punto de inicio para saber por dónde está investigando Bing, y la importancia que le están dando a la calidad de los resultados frente a la cantidad. Ahora sólo queda que el tiempo siga creándose y dentro de un tiempo ver si se aplican estos cambios.

Por cierto, como nota y detalle, si os fijáis en la imagen de BackRub, parece que Google «nunca» ha ordenado basándose en la cantidad de enlaces, sino en la calidad de los enlaces.

En fin, como siempre, los buscadores se basan en dos conceptos básicos: ingeniería y sentido común.

Deja una respuesta