Seguimos con las charlas de inteligencia colectiva (más concretamente con su uso en temas relacionados con las búsquedas).

Retomamos las charlas con Crowd Sourcing Literature Review in SUNFLOWER (de Sihem Amer-Yahia). La idea es generar contenidos de forma automática en base a resumir otros contenidos junto a la inteligencia colectiva.

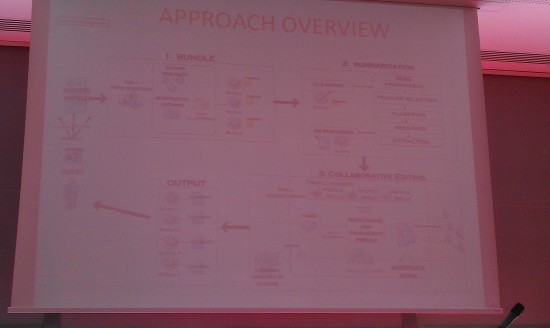

La primera parte lo que intenta es encontrar contenidos y buscar contenidos relacionados, generando distintos grupos y palabras clave. La segunda parte es la de generar un resumen de los contenidos (procesar, clasificar, reescribir…). La última parte es la que afecta a las personas. La idea es que en esta parte los usuarios acaben verificando y reescribiendo la documentación.

Para sacar los documentos se buscan contenidos similares y se basa también en los autores. Gracias a distintas herramientas ya existentes (como MEAD) se pueden extraer los principales conceptos y generar un resumen. La parte más relacionada con los usuarios tiene mucho trabajo por delante, ya que se pueden ajustar mucho los puntos para conseguir mejores contenidos finales. Como ejemplo de este sistema podríamos poner una base de la Wikipedia (podemos ver datos analíticos).

Para sacar los datos primero hay que encontrar documentos bien tratados, con temas y sub-temas. Además, han de estar bien relacionados, ya sea mediante palabras clave, información de autoría, sistemas de citas u otra metainformación.

Seguimos con la siguiente charla Human Computation Must Be Reproducible (de Praveen Paritosh).

La idea de lo que se ha comentado hasta ahora es sacar si los datos que se extraen de forma colaborativa son fiables. Freebase es una especie de Wikipedia pero pensada para máquinas con 23 millones de entidades y 500 millones de relaciones. En general el mayor problema de detección es el de las entidades. Por ejemplo, hay 8 ciudades llamadas San Francisco y hay que discernir de cuál de ellas se trata.

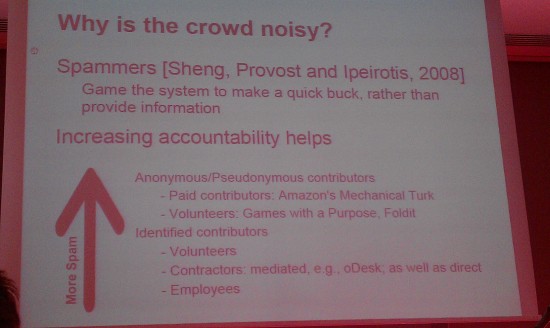

Hoy en día ¿para qué se usan las «computadores humanas»? Para etiquetar imágenes, para determinar relevancia en buscadores, moderar contenidos ofensivos… Estas personas pueden ser gente pagada (por ejemplo Mechanical Turks) o voluntarios, gente a través de oDesk o incluso empleados de la propia compañía (lo ideal es que sea una mezcla de todos ellos).

Los problemas del Crowd son, por definición, los spammers.

Además encontramos problemas en cuanto a las especificaciones de las tareas, a las guías de estilo de cómo han de responder. Aunque el problema mayor es la fiabilidad de la inteligencia colectiva, que requiere respuestas fiables y una serie de bases representativa.

A continuación tenemos Mechanical Cheat: Spamming Schemes and Adversarial Techniques on Crowdsourcing Platforms (de Djellel Eddine Difallah, Gianluca Demartini y Philippe Cudré-Mauroux).

¿Cómo se puede saber si una respuesta generada por los usuarios es spam? Por ejemplo que se haya contestado de forma aleatoria, que se haya generado de forma artificial o que sea duplicada de otra fuente. Para verificar esto es necesario el uso de algoritmos de selección y filtrado. En general las herramientas colaborativas tienen un bajo sistema de control del spam.

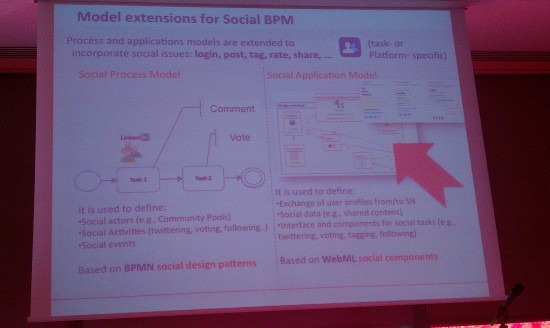

Para acabar, A Model-Driven Approach for Crowdsourcing Search (de Alessandro Bozzon, Marco Brambilla y Andrea Mauri).

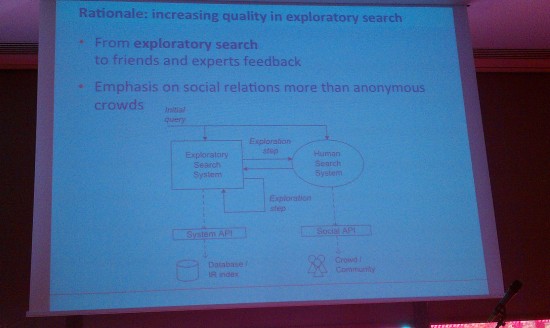

La idea es cómo sacar información de la gente cuando se realizan búsquedas. En general se hace una búsqueda y se va refinando hasta conseguir la respuesta. pero en algunos casos puede que la respuesta nos e ala óptima. Para esto se puede usar un sistema añadido que se basa en datos anónimos de otros usuarios.

La idea es que, tras extraer datos de distintas API, se permita enviar la consulta a tus amigos de diferentes plataformas sociales (tipo facebook) y demás que, en un tiempo limitado, decidan las respuestas para mejorar la consulta.

Deja una respuesta